第3回 パターン認識と機械学習(PRML) 復習レーン に参加してきた

第3回 パターン認識と機械学習(PRML) 復習レーン に参加してきました。

ATND: PRML復習レーン(第3回) : ATND

Google Group: Google グループ

Twitter Time Lineまとめ(Togetter)と、各講師の方々の資料、メモを、覚書きとして以下に記載します。

※各講師資料、アップされたら追加更新します。

第2章(前回)のおさらい

2.1 ([Twitter:@ajiyoshi])

2.2-3 ([Twitter:@nokuno])

ベイズ学習.pdf

id:nokuno さんのエントリ:http://d.hatena.ne.jp/nokuno/20100703/1278172465

2.4 ([Twitter:@_kohta])

§2.3.4 - 5 ([Twitter:@sleepy_yoshi])

§2.3.6 ([Twitter:@takmin])

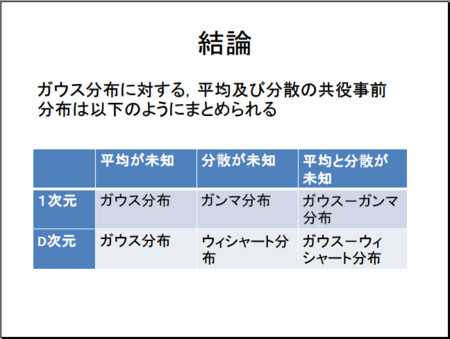

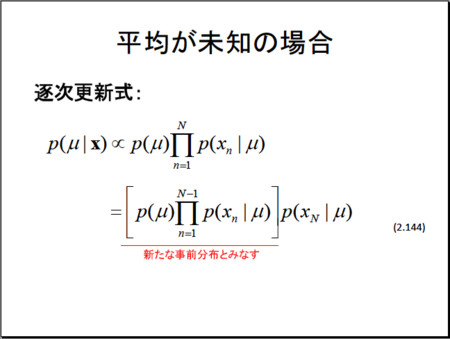

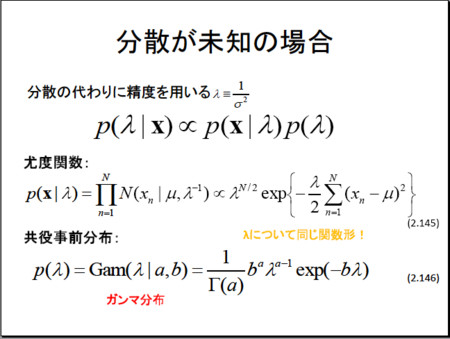

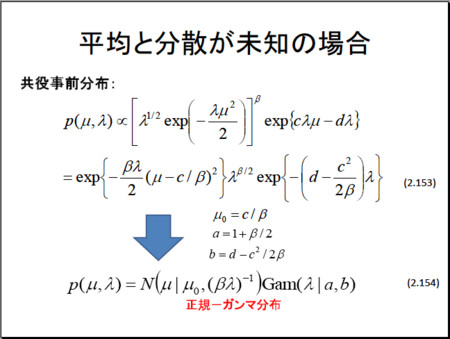

§2.3.6 ガウス分布に対するベイズ推論

[経歴] 画像認識のサービス開発・研究

技術連載記事:OpenCVで学ぶ画像認識:特集|gihyo.jp … 技術評論社

顔ちぇき:http://www.mobilefactory.jp/service/kaocheki/

コンピュータビジョン最先端ガイド勉強会:Google グループ

id:takmin さんのエントリ:第三回「パターン認識と機械学習」読書会復習レーンで発表してきました - takminの書きっぱなし備忘録 @はてなブログ

§2.3.7〜9 ([Twitter:@naoya_t])

§2.3.7 Studentのt分布

・外れ値の影響を受けづらい。ガウス分布に対し裾野が長いため(ガウス分布の無限和になっている)

・ガウス分布で、ガンマ分布を事前分布とし精度を積分消去

・ν=1で Cauchy分布

・ν→∞で 平均μ、精度λのガウス分布になる

・最尤解はEMアルゴリズムで算出

§2.3.8 周期変数

§2.4 ([Twitter:@jaisalmer992])

§2.4 指数型分布族

・ベルヌーイ分布(Bernoulli Distribution)

・ロジスティックシグモイド分布 (Logistic Sigmoid Function)

・多項分布 (Multinominal Function)

§2.4.1 最尤推定と十分統計量

§2.4.2 共役事前分布

§2.4.3 無情報事前分布

§2.5 ([Twitter:@sleepy_yoshi])

2.5.2 最近傍法

・各領域の中に入る点の数を固定する。入るまで領域を広げる。

・k近傍分類器:イメージ; k個の要素の多数決で結果を決める。

・誤分類率

参考:http://www.sakurai.comp.ae.keio.ac.jp/classes/infosem-class/2009/06Bayes.pdf

§3.1 [Twitter:@smly]

エントリ:http://d.hatena.ne.jp/smly/20100630/1277904761

3.1 線形基底関数モデル

3.1.2 最小二乗法の幾何学

3.1.3 逐次学習

3.1.4 正則化最小二乗法

基調講演 グラフスパース化[Twitter:@smly]

・b-マッチンググラフ による効率的なスパース化

・既存研究:半教師あり語義曖昧性解消。グラフスパース化 (k近傍グラフ)。

・半教師あり学習は計算量が大きい。データ類似度のO(n^2)の

・PVM(Zhang+, ICML 2009)

・AGR(Weit, ICML 2010):予測値を、アンカーポイントの予測値の線形結合として決める。

書籍

- 作者: C. M.ビショップ,元田浩,栗田多喜夫,樋口知之,松本裕治,村田昇

- 出版社/メーカー: シュプリンガー・ジャパン株式会社

- 発売日: 2007/12/10

- メディア: 単行本

- 購入: 18人 クリック: 1,588回

- この商品を含むブログ (111件) を見る

- 作者: C. M.ビショップ,元田浩,栗田多喜夫,樋口知之,松本裕治,村田昇

- 出版社/メーカー: シュプリンガー・ジャパン株式会社

- 発売日: 2008/07/11

- メディア: 単行本

- 購入: 19人 クリック: 443回

- この商品を含むブログ (64件) を見る